本記事では、日々の機械学習・データサイエンスのアウトプットをまとめていきます。

- 自分のアウトプットのため(&モチベ維持)

- 一個人によるブログやQiitaでのアウトプットが少ないため(企業サイトだとあまり参考にならない)

本記事の目的は上記の通りでして、自分の成長面と世の中のニーズがあると思ったため、記事にまとめようと考えました。

ちなみに本記事を書いている人のスペックは以下のような感じです。

- 大学院の研究で機械学習を使った材料設計を行なっている

- SEOマーケティング会社で実務を1年ほど経験

- 当メディアを運営(月間10,000PVほど)

- 2025年4月からIT事業会社のデータサイエンティストとして働く予定で、現在はBigQueryを活用したGA4やGSCのデータ分析に注力

現時点では、ようやく大学の研究で機械学習モデルが適用できたという圧倒的駆け出し段階です。(2022年11月時点での話です<(_ _)>)

いずれは当メディアやマーケティングの仕事にも活かせるようになりたいので、その過程も本記事で伝えられたらなと思います。

そんな感じの見切り発車で記事をまとめていきます。

※日々色んなタスクがあるので、本記事にまとめていく優先順位は低いです。めちゃゆる〜くゆる〜くアウトプットしていくつもりなので、ご了承ください ( ◜◡‾)

理系の大学・大学院生は「TECH-BASE」による機械学習スキルの習得がおすすめです。カリキュラムから学習支援、就活のサポートまで全て無料で受講できるため、お得に市場価値の高いスキルを身につけてキャリア形成に役立てていきましょう。

初期学習

まずは、僕がどのようにして機械学習・データサイエンスの基礎を身につけたのか、ステップごとに紹介していきます。

次に、スタアカという月額980円でAI / データサイエンスが学べるプラットフォームを活用しました。

Progateよりも安い金額でAI / データサイエンスが体系的に理解できたのはありがたかったです。

ディープラーニングの理論がめちゃわかりやすく解説されている神本(誰もがおすすめしている名著です)

これのおかげでディープラーニングの理解が深まりました。

多少回り道はしたものの、上記のステップが僕の基礎を作ってくれました。

ここからは日々アウトプットしつつ、研究や仕事に活かしていきたいです(*`・ω・)ゞ

また、下記ツイートのような考えはすごく大事だなぁと思います。

結局どれだけ難解な理論を身に付けたとしても、それを活かせなかったら意味ないという教訓です。

頭カッチカチおじさんにならないように気をつけていきます。

大学の研究によるアウトプット

ここでは大学の研究で扱ってきた機械学習モデルやアルゴリズムなどをアウトプットしています。

成長日記みたいな感じで載せていけたらな〜って感じでまとめているので、適当に見ていってください笑

2022年11月(Keras Sequentialモデル)

まずは研究で構築した学習モデルをアウトプットしていきます。

Google Colaboratoryで自前csvファイルのデータをニューラルネットワークで学習させて、回帰分析を行うといった内容です。

下記記事にてまとめているので、興味ある方はご覧ください。

2023年2月(Keras Functional API)

上記はKerasのSequentialモデルを扱っているのですが、Functional APIのモデルを扱った複数出力のニューラルネットワークを作る必要がありました。

その解説記事についても下記にてまとめています。参考までにどうぞ。

2023年6月(機械学習の逆解析)

今までにKerasで予測モデルを構築してきましたが、そのモデルを活用して逆解析していくアルゴリズムを作成しました。

- 順解析:機械学習モデルを構築して、入力から出力を予測する。(需要予測、気象予測などに応用)

- 逆解析:機械学習で学習済みのモデルを用意して、欲しい出力から入力を求める。(材料設計、マーケティング予算配分の最適化などに応用)

ざっくりと順解析と逆解析についてまとめてみました。

以下の記事ではもっと深ぼって解説しているので、ぜひ参考にしてみてください。

2023年9月(複数出力に対する逆解析)

2023年6月段階では1出力に対する逆解析しか実現できませんでしたが、複数出力に対して逆解析できるアルゴリズムを作成しました。

こちらはまだ記事にできてないので、僕が上げたGitHubのコードを共有しておきます。(またリソースがあるときに記事にまとめたい。)

2024年3月〜(敵対的生成ネットワークに興味あり)

現在、敵対的生成ネットワーク(GAN: Generative Adversarial Networks)に興味があって、そっちに研究の方向性を定めようと考えている最中です。

ここら辺の技術もアウトプットできるように頑張ります(*`・ω・)ゞ

データサイエンスのアウトプット

こちらは大学での研究以外での活動をまとめていきます。

2022年12月(アルゴ式共有)

まだ全くといっていいほどデータサイエンス的な活動はできてないですが、良い感じの学習サイトを見つけたので共有します。

アルゴリズムから統計、データサイエンスの部分まで、わかりやすい内容が完全無料で学習できる良いWebサービスです。

割と量がありそうなので、コツコツと学習していきます。

2023年4月〜12月(新卒のデータサイエンティスト就活)

この期間で新卒のデータサイエンティスト就活を行なっていました。

無事、大手IT事業会社のAIエンジニア・データサイエンティストとして内定をいただくことができ、2025年4月からそのようなポジションで働く予定です。

就職活動で得た知見などをアウトプットしている記事があるので、新卒でデータサイエンティストを目指す方はぜひご覧ください。

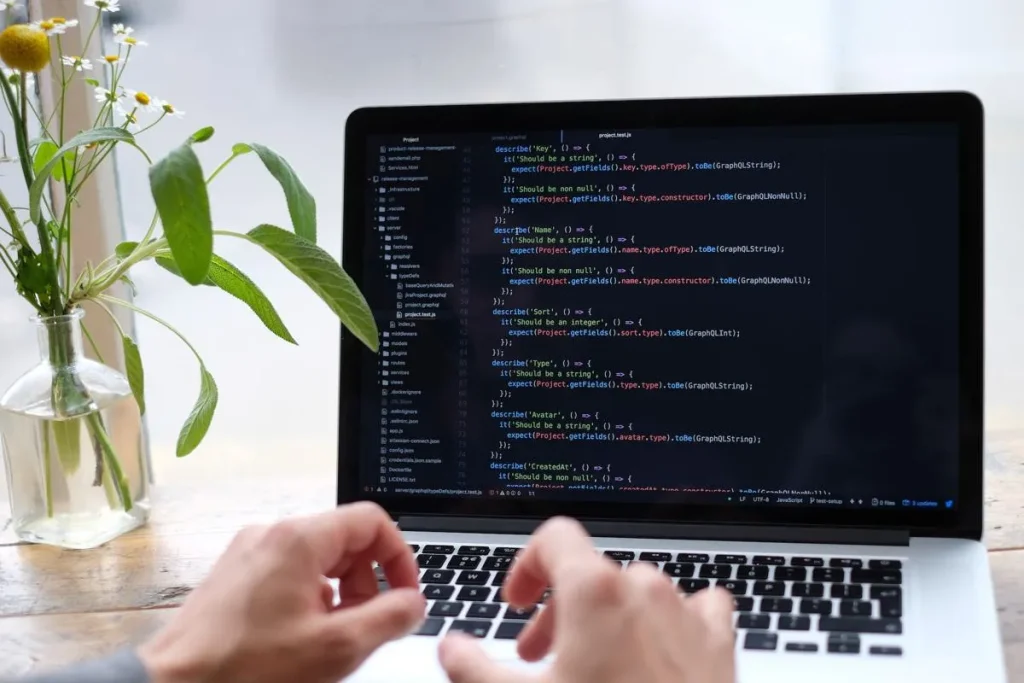

2024年1月〜(GA4✖️BigQueryで分析中)

現在、当サイトから得られるGoogleアナリティクスのデータをBigQueryで分析することにハマってます。

扱ったSQLのコードや、BI側での処理などをアウトプットできたらと思ってます!

一旦おわり。